La Oxford University Press eligió hace poco los términos "rage-bait" (cebo de rabia) como palabra del año. Como dice l'ex-senador Guido Girardi, "no es una simple anécdota lingüística, sino la manifestación de una grave patología social digital". "La gente propaga el odio, el miedo y la desinformación en las redes sociales como no se había visto nunca" afirma Amnistía Internacional. Algo parecido ocurre con mensajes que ensalzan las dictaduras militares o sus verdugos, como se ha observado recientemente en TikTok, con millones de visualizaciones en Argentina, Brasil, Chile y Uruguay (Flores).

"Los agresores, conocidos como "haters", suelen actuar motivados por la frustración, la envidia o la baja autoestima, y a menudo se amparan en el anonimato de internet para descargar su ira y buscar atención." (Gemini)

"En Twitter, el odio campa a las anchas, los algoritmos a veces promueven eso porque genera tráfico. No hay una política firme de moderación de contenidos", dice Manuel Gámez, doctor en psicología (Casamitjana).

José María Lassalle, doctor en derecho, escritor y profesor universitario, lo explica por el hecho de que, a través de las pantallas, "tenemos más capacidad de ser agresivos sin percibir de manera nítida como afecta el comportamiento al otro". "En todo esto se juega la baza de que el anonimato es difícil de rastrear", agrega Pablo Hernández, coordinador de Investigación Académica de Maldita.es, portal de fact checking (ibidem).

Se apela muchas veces a la libertad de expresión, pero esto "no deja de ser un «mecanismo de desconexión moral» bajo el que se busca tranquilizar la conciencia", según Manuel Gámez (ibidem).

Las empresas tecnológicas han descubierto en las investigaciones de neurología que los circuitos cerebrales relacionados con las emociones operan con más rapidez que los relacionados con la reflexión racional y se aprovechan de ello para influir en nuestras decisiones y opiniones. Encontramos ahí la explicación de varios fenómenos observables en casi todos los países: el aumento de la violencia y la polarización en materia política. La ira es solo uno de los aspectos de la violencia y también de las publicaciones políticas, a lo cual habría que agregar el ciberacoso. Se estima que 70% de las personas la experimentan bajo una forma u otra.

Pero esto no es el producto casual de los algoritmos y no es un resultado inesperado:

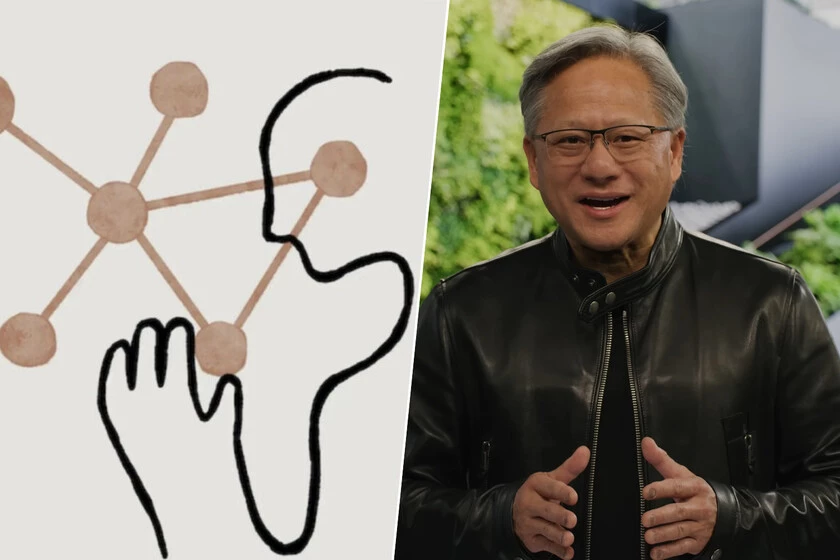

"El rumbo actual del desarrollo de la inteligencia artificial no es el resultado de un avance inevitable ni de una lógica neutral, sino de elecciones deliberadas tomadas por un reducido grupo de empresas y ejecutivos, principalmente en Silicon Valley." (Morales/a)

Hay una opción deliberada por la amplificación de los contenidos negativos:

"Los algoritmos, para asegurar el flujo constante de datos, amplifican sistemáticamente el miedo, la amenaza, la falsedad y la indignación: es decir, aquello que representa lo peor de la especie humana. (...) El corolario es la erosión acelerada de atributos esenciales que nos definen: la empatía, la capacidad de cooperar y, sobre todo, el pensamiento crítico." (Girardi)

"En Silicon Valley, no importa cuál sea la intención original de uno, siempre se trata de ganar [dinero]." Y es "una ambición que se impone a la ética", según Karen Hao, reportera de MIT Technology Review, autora de "Empire of AI" (Honan). El mismo Sam Altman dijo que Open AI no era "la policía moral del mundo" (Babiloni).

"Los objetivos y parámetros propios de la publicidad se convirtieron en los objetivos y parámetros principales del diseño de servicios digitales. De lo que se trataba era de maximizar el tiempo de uso y la atención del usuario. Con el fin de competir en esta carrera despiadada por captar nuestra atención, se forzó al diseño a apelar a los impulsos más bajos del ser humano y explotar sus debilidades cognitivas." (Williams, 46-47)

Se ha hablado de la "economía de la atención" y ésta se ha orientado especialmente hacia la atención por lo negativo.

También Daniel Innenarity considera que "detrás de la concepción neutra o necesariamente benefactora de la tecnología hay esa mentalidad ingenieril que sólo se preocupa de que los artefactos funcionen, que generen beneficios, sin atender a su impacto social." (p.209)

Hay otro campo donde el odio o la rabia pueden producir beneficios aunque no necesariamente económico: la política. Como dice Guillermo Mimica, abogado y escritor:

"Desde tiempos inmemoriales, la bronca que expresa resentimientos reprimidos ha sido un vector movilizador que ha modelado la historia. Las grandes revoluciones y cambios estructurales en los sistemas políticos, sociales, religiosos, económicos han sido motivados por el sentimiento de injusticia de los insurgentes, canalizado por liderazgos que lo estructuran para dar curso a cambios radicales una vez conquistado el poder."

La política recurre a las redes sociales no solo para informar sino también para motivar, especialmente en período electoral o cuando pretende, justamente, producir cambios estructurales, que son los períodos en que, muchas veces, recurre a incentivar la rabia. Lo hemos conocido especialmente en Chile en 2019, con el “estallido social” que "fue la máxima —pero no la única— manifestación de esa rabia colectiva que buscaba una salida de fuerza que se perfilaba para la toma del poder" (Mimica). El odio también está siendo utilizado por Donald Trump, por ejemplo en su guerra con la prensa, donde llega a "condicionar a sus seguidores a creer —creer genuinamente— que los periodistas son enemigos traidores del pueblo" a juicio de Monika Bauerlein, como también en su campaña contra los inmigrantes.

Pero la política también empieza a preocuparse por los efectos en la seguridad del desarrollo de la ira a través de las redes sociales: Australia está desarrollando un paquete de leyes para frenarla, tras un tiroteo que se saldó con 15 muertos (Euronews).

Diversos estudios vienen, desde hace tiempo, advirtiendo de los efectos de las redes sociales en el cerebro en el caso de los adictos. Ya lo he explicado en mi libro "¿Ser digital o ser humano" (2015). En 2024, un análisis de The Washington Post reveló el mismo fenómeno de activación de los circuitos de recompensa del cerebro "facilitando la formación de hábitos difíciles de romper" en el caso de TikTok y aseguró que es "el resultado de un diseño intencionalmente orientado a fomentar hábitos adictivos" (Neira).

El ser humano está siendo transformado (menos humano) y también la sociedad: "Una humanidad polarizada y fragmentada por los algoritmos se traduce inevitablemente en la muerte de la deliberación civilizada y, por extensión, de la democracia." (ibidem)

En 2019, "en respuesta a las tendencias alarmantes de aumento de la xenofobia, racismo e intolerancia, misoginia violenta, antisemitismo y odio a los musulmanes en todo el mundo", António Guterres presentó la Estrategia y Plan de Acción de las Naciones Unidas para la lucha contra el Discurso de Odio, que "proporciona una hoja de ruta de cómo la Organización puede ayudar y complementar los esfuerzos de los Estados por atajar este problema", y en 2021, la Asamblea General adoptó una resolución que proclamaba el 18 de junio Día Internacional contra el Discurso de Odio. (ONU)

En la Unión Europea, la Ley de Servicios Digitales (DSA) de 2022 obliga a las plataformas a eliminar contenido ilegal como el discurso de odio, y se complementa con un Código de Conducta para combatir la incitación al odio en línea. Como esto afecta las plataformas de redes sociales ha molestado al gobierno de Donald Trump y el Departamento de Estado ha anunciado que revocará las visas, prohibirá la entrada y deportará a quienes apliquen dicha ley (Sahuquillo).

Fei-Fei Li, profesora en la Universidad de Stanford, también advirtió de los riesgos sociales - y otros - asociados a la IA y creó en Stanford el Instituto para la IA Centrada en el Humano. En la Ai4 Conference de Las Vegas, de agosto pasado, defendió que la tecnología debe estar al servicio de las personas.

"Ha centrado gran parte de su carrera en impulsar una inteligencia artificial que incorpore principios de empatía, responsabilidad y colaboración interdisciplinaria. Su visión parte de la convicción de que la IA no debe ser diseñada solo como una hazaña técnica, sino como una infraestructura global, capaz de mejorar la vida humana, ampliar la creatividad y favorecer la toma transparente de decisiones." (Morales/b)

El ya citado reiteradas veces por mí Geoffrey Hinton defiende la misma posición y, como expuse en otros posts, las demandas por un control ético de la IA son numerosas pero la resistencia de las empresas es fuerte.