Las referencias a los

big data y al análisis de los mismos remiten casi siempre al uso de procedimientos de "inteligencia artificial" para extraer información. Pero es necesario introducir algunas precisiones en torno a este concepto.

Problemas de definición

No es difícil definir "artificial" ya que, simplemente, es algo que no existe en la naturaleza. Pero definir "inteligencia" puede ser un problema porque no todos los filósofos o psicólogos entregan la misma explicación. El mismo David Chalmers, un experto en el tema, sugirió incluso el año pasado que no se debía esperar unanimidad siquiera en este siglo. Y John McCarthy, un pionero de la IA en la Universidad de Stanford abordó la cuestión en noviembre de 2007:

"Q: ¿No hay una definición sólida de inteligencia que no depende de relacionarlo con la inteligencia humana?

R: Todavía no. El problema es que todavía no podemos caracterizar, en general, qué tipo de procedimientos computacionales queremos llamar inteligente. Entendemos algunos de los mecanismos de la inteligencia y no a otros." (Agenda Wold Economic Forum, 7/09/2015).

A pesar de ello, Marcus Hutter y Shane Legg han propuesta la siguiente definición general: "la inteligencia mide la capacidad de un agente para lograr objetivos en una amplia gama de entornos" (ibidem). Pero podría ser demasiado amplia (¿no hay muchos programas de computación que logran ésto pero que nadie consideraría "inteligente"?) y es dudoso que consigan una aceptación unánime, especialmente por parte de los psicólogos.

Inteligencia de máquina

Ante todo, ¿que significa realmente "inteligencia artificial"? El concepto es fruto de unas famosas conferencias que tuvieron lugar en 1956 en el Dartmouth College, en Hanover (New Hampshire, Estados Unidos). Los investigadores reunidos ahí discutieron acerca de la posibilidad de construir máquinas que no se limitaran a hacer cálculos prefijados sino operaciones genuinamente "inteligentes". Y, para ello, se inspiraban en los trabajos de Alan Turing quien, deseoso de crear un cerebro artificial, inventó la siguiente prueba:

Un interrogador permanece encerrado en una pieza, enviando mensajes por un buzón a dos interlocutores, un hombre y una mujer, siendo su objetivo determinar quién es el hombre y quién la mujer (sin preguntar, obviamente, por el sexo de cada uno). En el modelo inicial de la prueba, se supone que el varón quiere hacerse pasar por mujer. Luego se pregunta: ¿qué ocurrirá si el varón es reemplazado por una máquina? Si el diálogo que ocurra y el número de errores en la solución dada se acerca al número de errores ocurridos en la comunicación con un ser humano, se podrá estimar -según Turing- que estamos ante una máquina "inteligente".

(Tengamos en cuenta que la diferencia de sexo era mucho más fácil de descubrir en su época -1950-, razón por la cual este aspecto desapareció en las aplicaciones (y en muchos comentarios) posteriores de este test. Esto significa que las exigencias -para equiparar la máquina y el sujeto que trata de engañar- eran bastante modestas.)

A partir del grupo del Darmouth College, se formaron dos grandes "escuelas" de IA: la de la Universidad de Carnegie-Mellon que se propuso desarrollar modelos de comportamiento humano con aparatos cuya estructura se pareciese lo más posible a la del cerebro (lo que posteriormente derivó en los trabajos sobre redes neuronales artificiales) y la del Instituto Tecnológico de Massachusett (MIT), que se centró más en que los productos del procesamiento tuvieran el carácter de inteligente, sin preocuparse por el funcionamiento o la estructura de los componentes (lo cual se podría eventualmente lograr con computadores normales).

En la propuesta de Turing -y en las fórmulas mejoradas del test que se han construido después- es importante tener en cuenta que la definición de la inteligencia está íntimamente relacionada con el protocolo que se estima correcto para determinar su existencia. Desde este punto de vista, Turing habría concebido el test de tal modo que fuese fácil considerar a los computadores como "inteligentes", ya que se "define" la inteligencia como lo que el computador logra demostrar en dicho test. Pero es una definición muy peculiar (y limitada) de la inteligencia, como han recalcado los psicólogos expertos en desarrollo de la inteligencia, los cuales han aportado múltiples argumentos que tienden a situar la inteligencia fuera del alcance del protocolo del Turing. Suponiendo que una máquina pasa con éxito el test de Turing (incluso con mayores exigencias), estaremos frente a un ente que reacciona adecuadamente, pero ello no implica que tenga entendimiento (o que sea realmente "inteligente" al modo humano). (H. Collins).

El análisis del lenguaje fue una de las áreas en que más se trabajó. Se descubrió pronto que el mero reconocimiento del léxico no llevaba a ninguna parte y los trabajos de Chomsky llevaron a estudiar cómo era posible convertir una cadena lingüística -con una estructura determinada- en otra, lo cual sería clave para los sistemas actuales (aunque se ha renunciado a aplicar directamente sus ideas). Se llegó así a reconocer que la comprensión del lenguaje se demuestra fundamentalmente en la capacidad de parafrasear, es decir de referirse a un mismo contenido cambiando su forma de expresión (cfr. Schank, pp.108-109).

"Aunque se han dado ciertos avances, no se ha solucionado el problema del sentido común y las computadoras siguen sin poder enfrentarse a entornos poco formalizados. Hemos descubierto que la inteligencia no se reduce a mero cálculo (en lo cual las máquinas son las campeonas), sino que hay muchos tipos de inteligencias muy interconectadas: hay inteligencia social, emocional, creativa… ¿Cómo implementar en una máquina algo parecido a una emoción? No hay ingeniero en el mundo que tenga la más remota idea de cómo hacerlo." (Sánchez-Migallón)

Sistemas expertos

Aunque se habla de las interfaces de voz como Siri y Cortana como sistemas de IA, en realidad son solo sistemas expertos, que corresponden a una fase inicial de desarrollo de la IA (por esta razón implantable hoy en aparatos como los smartphones, ya que utilizan menos recursos). Contienen información básica que les permiten realizar operaciones en un dominio muy específico y, actualmente, pueden además "aprender" a partir del uso que se les da (básicamente a partir de una estadística de los términos dictados). Sin embargo, solo han sido posibles gracias a trabajos previos de poderosos computadores funcionando de forma paralela y aprendiendo patrones a partir de enormes volúmenes de información. Este trabajo ha sido mérito de Google, que reunió en 2008 en sus computadores la información entregada por sus usuarios, logrando llevar la cifra de aciertos, de acuerdo a sus investigaciones, al 90% de exactitud en el reconocimiento del habla humana. (BBC Mundo, 15/09/2015).

Minería de datos

Es un método de investigación propio de la “ingeniería de sistemas” destinado a explorar grandes conjuntos de datos para sacar de ellos conocimientos nuevos que, de otro modo, permanecerían por siempre escondidos. Consiste esencialmente en encontrar, entre los objetos representados, relaciones que serían imposible de encontrar de otra forma. Se aplica a cualquier tipo de Base de Datos con grandes cantidades de registros cuyos contenidos sean principalmente numéricos. Ha sido utilizado para investigar fraudes y el crimen organizado, en análisis financiero (bancos, bolsas), telecomunicaciones (operación de redes), medicina (influencias de la interacción de medicamentos), etc. El motor de búsqueda de Google es un ejemplo de IA de este tipo. (He analizado detalladamente esta técnica en mi libro "Explotar la información noticiosa", disponible en ISSUU.)

Aprendizaje de máquina

El aprendizaje de máquina pretende inducir conocimiento a partir de la acumulación de información no estructurada suministrada en forma de ejemplos o casos. Esta acumulación se complementa con los datos de las operaciones realizadas y cada resultado positivo de las búsquedas refuerza los circuitos (algoritmos) que facilitan la obtención de mejores respuestas. De este modo, la programación apunta a generalizar comportamientos o diseñar soluciones factibles a diversos problemas específicos.

Este tipo de técnica existe desde al menos 30 años. Si no se utilizó con frecuencia anteriormente, es porque no se contaba con computadores capaces de utilizarla con suficiente rapidez y grandes cantidades de datos. Si el supercomputador Watson es capaz de responder correctamente a la pregunta "cuáles son las mayores ciudades de Estados Unidos", es porque es capaz de encontrar muchas variantes de frases como "Nueva York es la mayor ciudad" o "no hay ciudad mayor que Nueva York" y porque dispone de un cuerpo (base de datos) muy grande de informaciones. Lo mismo hace Google cuando compara fotos y es capaz de distinguir entre un perro y un gato (y otros animales u objetos).

IBM lo ha llamado "computación cognitiva" y lo ofrece comercialmente como

servicio de Watson. Así, en el Centro para el Cáncer MD Anderson de Houston (EEUU) hay una versión de Watson que ayuda a los médicos a desarrollar regímenes de tratamiento a partir de los síntomas de un paciente en base a un análisis de miles de páginas de artículos médicos y anotaciones de doctores. IBM también anunció el lanzamiento de

Watson Personality Insights en español a través de Bluemix, servicio que utiliza el análisis lingüístico para inferir la personalidad y características sociales a partir del análisis de texto (Transmedia, 18/08/2015).

Lo más novedoso, en el campo del aprendizaje automático parece ser el sistema desarrollado por Affectiva, una start-up de Waltham, Massachusetts, que puede descubrir las emociones ocultas mediante la observación de los movimientos de la cara. El enfoque le permite saber qué siente la gente a cada momento, mientras un anuncio aparece en la pantalla, y no sólo lo que se dice una vez que ha terminado. El software de Affectiva identifica primero marcadores faciales importantes, como la boca, las cejas y la punta de la nariz. A continuación, los algoritmos de aprendizaje automático siguen los movimientos de esas regiones o cómo cambia la textura y el color de la piel a lo largo del vídeo. Estos cambios se analizan en expresiones discretas que indican los cambios emocionales.

Los investigadores descubrieron después que podían usar los datos faciales para predecir con precisión los resultados en encuestas personales, lo que sugiere que se puede confiar en el análisis computacional para saber si un anuncio es exitoso. Piensan que, en el futuro, el sistema podría servir a los servicios de televisión como Netflix para producir programas de televisión o películas más agradables. (

New Scientist, 16/09/2015)

Una forma avanzada de este tipo de aprendizaje es el aprendizaje por "refuerzo profundo" (deep learning), que realiza estas operaciones mediantes redes neuronales artificiales.

Redes neuronales

Las redes neuronales artificiales intentan imitar las conexiones de las neuronas cerebrales.

"Para comprender las operaciones básicas del tipo más simple de red neural, imaginen tres nodos de entrada dispuestos en una columna y una columna de dos nodos de salida a la derecha de los de entrada. Cada uno de los tres de entrada está conectado por cables a cada uno de los dos de salida; pero en la mitad de cada cable hay un interruptor que puede cerrar el paso de la corriente eléctrica a través del cable desde el nodo de entrada al de salida. Cuando se expone cualquiera de los tipos de nodos a una corriente lo suficientemente grande, se dice que el nodo está «activo»; cuando la corriente es muy pequeña o inexistente, está inactivo. Para resolver un problema con una red de este tipo, se puede asignar a cada nodo de entrada la representación de un rasgo particular del problema [y atribuir un determinado significado a los de salida] [...] Por supuesto, la clave para que la red produzca la respuesta correcta está en ajustar los interruptores entre los nodos de entrada y de salida. En las redes más sencillas, este ajuste puede ser simplemente cosa de abrir o cerrar por completo cada uno de ellos". (Freedman, pp.90-91)

Sin embargo, no se usan hoy simples interruptores (sistema binario) sino sistemas que permiten ajustar los valores en una escala contínua (potenciómetros). Se habla así del "peso" de una conexión, el que debe ser ajustado para que una determinada entrada produzca la salida correcta, tarea bastante difícil si no se cuenta con un sistema que permite a la red "aprender" de sucesivas experiencias.

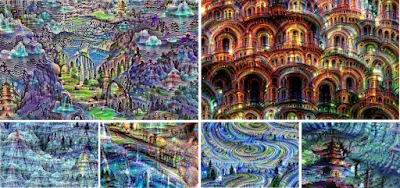

El desafío con estas redes es comprender exactamente qué proceso ocurre en cada capa: "Por ejemplo, la primera capa puede buscar por los bordes o esquinas de los elementos de la fotografía. Las capas intermedias interpretan las características básicas para buscar formas o componentes, como una puerta o una hoja. Y las últimas capas arman ésto en una interpretación completa, las que se activan en respuesta a cosas complejas como edificios o árboles". Pero los resultados pueden ser impredecibles:

Lo que Google ha hecho es una labor de lo que llaman «incepcionismo»: resaltar sobre una imagen convencional las diferencias y detalles que el software reconoce de forma más acusada. De este modo logramos ver algo así como «lo que llama la atención a la inteligencia artificial», algo que normalmente no se ve pero que está dando vueltas por los circuitos de memoria (Microsiervos, 19/06/2015) .

Yahoo y Google utilizan este tipo de redes (simuladas en un supercomputador) para el reconocimiento de rostros. Pero la respuesta no siempre es correcta como lo demostró lo ocurrido en Google al etiquetar como gorilas a dos personas de color, por lo que el mismísimo arquitecto jefe de Google+, Yonatan Zunger, debió disculparse, aclarando que el problema no era exclusivo de los afroamericanos, ya que también habían tenido problemas con personas blancas que habían sido etiquetadas como perros y focas, debido a que el aprendizaje de la red de IA era difícil y, por ahora, requiere la intervención de supervisores que "afinen" permanentemente el sistema para descartar los malos resultados. (MIT Technology Review, 16/02/2015; imagen adjunta).

Goggle también usa su programa DeepMind para "enseñar a leer" a sus computadores. Sus redes neuronales pueden responder a un 60 por ciento de las consultas formuladas acerca de los artículos conservados (MIT Technology Review, 19/06/2015).

Microsoft es otro de los competidores y consigue por ahora una calificación del 29.1%, lo que equivale a que 3 de cada 10 veces sus respuestas son al menos tan buenas como las que podría brindar un humano. La idea es utilizarla para crear subtítulos (pies de fotos). También es el sistema, llamado

Memory Network, que Facebook está desarrollando para procesar textos y responder cualquier pregunta acerca de los mismos (

MIT Technology Review, 26/03/2015).

Se trabaja ahora en mejorar aún más estos sistemas para llegar a un nivel en que la máquina pueda demostrar su competencia a la hora de analizar una imagen "comprendiendo" qué ocurre en la escena y no solo identificar objetos, o sea pasar de algún modo el test de Turing aplicado a las imágenes. En ello trabaja el profesor Stuart Geman y compañeros suyos de la Universidad Brown, en colaboración con DARPA. (Xataka, 11/03/2015; imagen adjunta)

Algoritmos evolutivos

"Una floreciente vía de investigación en los últimos tiempos es la llamada IA bioinspirada: aprender de los seres vivos. Se crean entornos virtuales en los que se sitúan “organismos” con distintas características para ver cómo evolucionan. La gran idea está en lo que se denomina algoritmo genético o evolutivo. Se propone un objetivo y se ponen a infinidad de “bichos” a intentar conseguirlo. Luego se introduce en cada uno de ellos una variación aleatoria (una mutación). A los que la variación no les mejore para conseguir el objetivo o, incluso, les perjudique, se eliminan. Los que mejoren siguen y se les introduce una nueva mutación aleatoria. Así, tras muchas generaciones, obtendremos seres altamente especializados en lo que queremos obtener. Todo consiste en copiar la selección natural darwiniana, pero acelerarla tanto como nos permiten hoy nuestros computadores." (Sánchez-Migallón)

La NASA utilizó ya este tipo de programación para resolver problemas de conexiones diseñando nuevos tipos de antenas para microsatélites en órbita.

El futuro

Por cierto falta mucho para llegar a robots al estilo de los de Asimov, con una inteligencia casi humana. Por ahora, los esfuerzos de desarrollo de la IA van en otra dirección, conducidos por los intereses económicos. La inteligencia artificial, ya presente en los otros negocios de Google, jugará un papel primordial en sus vehículos autónomos. Para ello, el año pasado contrataron a Geoffrey Hinton, una de las mentes más brillantes en la materia. Apple también estaría trabajando en el desarrollo de su propio modelo de coche y, según Reuters, estaría por contratar hasta 86 personas para incrementar sus efectivos en inteligencia artificial.

Pero ambos se encontrarán con una fuerte resistencia de la industria automotriz, que está llevando a cabo actualmente una verdadera guerra por contratar sus propios expertos en IA. ¿Por qué? Porque también tienen a la vista el desarrollo de los coches autónomos y necesitan buenos sistemas de IA para conducirlos. Y no quieren dejar que sistemas como Android Auto y (Apple)CarPlay acaparen a sus clientes, quedando ellos relegados a simples usuarios de un producto

commodity. Las soluciones propias les dan mayor independencia. Así, según Bloomberg, Toyota ha contratado a la "cabeza pensante" del equipo de ingeniería de inteligencia artificial del ejército estadounidense, que ayudaría a incorporar en sus vehículos sistemas de seguridad que le permitan reducir el número de accidentes en las carreteras. Está invirtiendo 50 millones de dólares en la investigación de tecnología relacionada con inteligencia artificial y el coche autónomo. General Motors, Ford y Honda también están invirtiendo grandes sumas en I+D. Uber también contrató a 40 investigadores del departamento de inteligencia artificial de Carnegie Mellon, dejando ahí un departamento diezmado. ¿Su objetivo? Con coches autónomos ya no necesitarían a sus conductores, evitando numerosos quebraderos de cabeza. (

Xataka, 16/09/2015)

Todas las técnicas señaladas son "muy primitivas" a juicio de Rafael Yuste, ideólogo del Proyecto BRAIN ((Investigación del Cerebro a través del Avance de Neurotecnologías Innovadoras), cuyo fin último es mapear la actividad del cerebro, lo que permitirá desarrollar técnicas para alterar la actividad de circuitos neuronales y, de esa manera, corregir los defectos que provocan las enfermedades mentales, entre otras utilidades. BRAIN involucra a laboratorios de muchos países, requiere cientos de millones de dólares para ser financiado (una parte de los cuales aseguró el presidente Obama) y la dedicación de investigadores de distintas disciplinas. (

One, El País.com, 16-09-2015)

Referencias:

BBC: "

15 key moments in the story of artificial intelligence"

Colle, R.: Explotar la información noticiosa - “Data Mining” en el Periodismo, Ed.Depto de Biblioteconomía y Documentación, Universidad Complutense de Madrid, 2002. Disponible en

ISSUU.

Collins, H.: Experts artificiels - Machines intelligentes et savoir social, Paris, Seuil, 1992.

Freedman, D.: Los hacedores de cerebros, Santiago de Chile, A.Bello, 1995.

Hammond, K.: "

Why artificial intelligence is succeeding: Then and now", Computer World, 14/09/2015.

Knight, W.: "

Watsoncito, Watsoncito, ¿hacia dónde debe IBM redirigir su negocio?", MIT Tecnology Review, 7/11/2014.

Pastor, J.: "La Skynet benévola: los ordenadores "conscientes" están cada vez más cerca", Xataka, 9/12/2014.

Penalva, J.: "

Este es uno de los nuevos exámenes que tendrán que aprobar las máquinas avanzadas", Xataka, 11/03/2015. Penrose, R.:Las sombras de la mente, Barcelona, Critica, 2007.

Pratt, I.: Artificial Intelligence, Londres, Macmillan, 1994.

Sánchez-Migallón, S.: "

El gran debate sobre si será posible o no una inteligencia artificial", Xataka, 18/08/2015.

Schank, R.: El ordenador inteligente, Barcelona, A.Bosch, 1986.

Searle, J.: Mentes, cerebros y ciencia, Madrid, Cátedra, 1985.

Simonite, T.: "

Demis Hassabis, Founder of DeepMind Technologies and Artificial-Intelligence Wunderkind at Google, Wants Machines to Think Like Us", MIT Technology Review, 3/12/2014.

Zamorano, E.: "

Conoce las lisérgicas imágenes que crea una inteligencia artificial tratando de reconocer fotos, FayerWayer, 19/06/2015.

Foto inicial: "I Robot" (24.media.tumblr.com)