En la presentación de mi nuevo libro "Sistémica de los medios de comunicación" (ver posteo anterior), el dr. Sergio Godoy planteó que es "positivista y frío". Me parece que conviene aclarar el concepto y, al mismo tiempo, mi posición al respecto.

1. ¿Que es el positivismo?

El positivismo, fundado en Francia por Auguste Comte (1798–1857), para luego expandirse a toda Europa, apareció como respuesta a las dificultades que presentaban el empirismo (Bacon, Hobbes, Locke y Hume) y el racionalismo (Descartes).

Se caracterizó por el rechazo total de la metafísica, que había influido en las concepciones anteriores, especulación a la que consideró como el principal enemigo de la ciencia y de la filosofía. Así, los positivistas preconizaron la aplicación de un método inspirado en el modo de operar de la ciencia física, “que triunfaba claramente en el dominio de la naturaleza y en las aplicaciones técnicas que de ella se derivaban. La ventaja fundamental de este método es su formalización y la posibilidad de expresar sus leyes en lenguaje matemático, que hace posible la construcción de modelos teóricos a partir del rigor del cálculo” (Wikipedia). Para el positivismo, la ciencia parte de la observación de los fenómenos y, a partir de ellos, intenta explicarlos elaborando teorías que reúnen leyes generales. Rechaza toda búsqueda de propiedades ocultas: solo admite “lo real” observado. Para Comte, incluso los problemas morales y sociales podían ser abordados de esta forma (Ahí nació la sociología).

2. El positivismo en la ciencia

Frente a este modo de abordar y pretender ampliar el conocimiento surgió una opción diferente, inspirada en la herencia kantiana: la fenomenología, que pretende estudiar y describir las cosas "tal y como se manifiestan y se muestran en la conciencia". Con ello, creía poder penetrar en la esencia de los fenómenos para encontrar el fundamento de la realidad. Frantz Brentano, Edmund Husserl y Martin Heidegger son sus principales exponentes. “Husserl pretendió encontrar una «evidencia intuitiva» o intuición de esencia a través de lo fenomenológico que viene a ser una especie de intuición trascendental, en sentido kantiano, que restaura, de alguna forma, la intuición clásica de la objetividad del conocimiento” (Wikipedia). Pero de este modo vuelve a introducir concepciones filosóficas de tipo idealista que, en último término, solo llevarían a hipótesis difíciles de contrastar, por lo que la ciencia moderna ha preferido definitivamente el positivismo, que ofrece mayores garantías. Pero es sin duda una concepción demasiado estrecha de la ciencia, porque es esencialmente materialista y el conocimiento engloba dimensiones que escapan a la metodología positivista (cfr. K.Wilber, "Ciencia y religión", Kairos, 1998).

3. El análisis de sistema

La ciencia moderna tiene una evidente inspiración positivista en su modo de abordar la realidad, especialmente el mundo físico. El positivismo nos puede decir mucho sobre el reino sensorial, un poco sobre el reino mental y nada sobre el reino contemplativo. Su error ha sido de pretender que solo lo medible puede ser objeto de conocimiento científico.

La modelización sistémica, que emergió con fuerza a mediados de los años setenta, a raíz de la publicación de la obra de L. von Bertalanffy "General system theory, foundation, development, applications" (1968), ha demostrado desde entonces una extraordinaria fecundidad así como una aplicabilidad que va desde la biología (su origen) hasta la sociología, pasando por la mecánica y la informática, e incluso la lógica, la epistemología y -como lo mostró mi libro anterior "Teoría cognitiva sistémica de la comunicación"- la psicología.

La teoría de sistemas es una teoría basada en la modelización. Pero la confección de modelos es también una idea reciente en la ciencia, propia del Siglo XX. Es un método de representación del conocimiento de tipo axiomático-inductivo, que se aleja por lo tanto de los más tradicionales métodos hipotético-deductivos. El método sistémico, tanto como la modelización, es por lo tanto una opción epistemológica, cuyos postulados se oponen a los del positivismo típico de las ciencias naturales y físicas

clásicas y son particularmente útiles en el campo de las ciencias humanas. En este campo, los postulados empírico-inductivos proponen considerar, metodológicamente, que:

"- No existe ninguna realidad objetiva dada: la realidad humana es una realidad de sentido (ligada a los significados) y es construida por los actores. Por otra parte la «realidad» de que se trata es siempre una construcción colectiva que no tiene la materialidad de un objeto físico del mundo; es siempre una construcción (concepción idealista o constructivista de la realidad).

- No existe UNA realidad objetiva dada sino varias realidades («realidades secundarias») construidas por los diferentes actores y coexistentes al mismo tiempo, tan «verdaderas» unas como otras (negación del principio del tercio excluido). Son, por ejemplo, las creencias de diferentes actores que son todas «verdaderas» desde su punto de vista.

- Un fenómeno, como una realidad secundaria, no existe nunca sólo. Existe necesariamente en relación con otros fenómenos. Estos fenómenos se vinculan unos a otros, forman un sistema. Ya no se puede decir que tal fenómeno «causa» tal otro, ya que hay siempre circularidades de interacciones. Los fenómenos están ligados por una relación de «causalidad circular», varios fenómenos están ligados en múltiples causalidades sistémicas.

- Si una realidad de sentido emerge, no se debe a una (o varias) causa(s) sino a un conjunto de causalidades circulares en las cuales la realidad emergente misma tiene un lugar (negación del principio positivista de la causalidad lineal).

- En lo que concierne al hombre y a los actores sociales, de modo general, hay que contar también con la causalidad final o teleológica. La causa ya no es solamente una causa previa, es también un proyecto, una orientación de los esfuerzos para lograr una meta situada en el futuro." (A. Mucchielli, p.11, citado en p.78 de la versión impresa de mi libro "Teoría cognitiva...")

Investigar de acuerdo a este enfoque implica que no se parte de una formulación de hipótesis que se contrasten luego mediante experimentación, sino que se formula una pregunta general y se pasa a recopilar numerosos datos que luego se categorizan y se ordenan para tratar de llegar a un esquema que ayude a entender el funcionamiento de los fenómenos estudiados.

Esta forma de trabajar puede explicar el calificativo de "frío" en el caso del libro comentado por S.Godoy, en particular porque no profundizo en las "circularidades causales", mencionando solamente relaciones e influencias, desde la perspectiva de la llamada "teoría del actor-red" pero sin aplicar extensivamente dicha teoría (que domino mucho menos pero merecería ser la base de otro trabajo).

3. Mi posición

Debe haber quedado claro que no rechazo en absoluto la metafísica, pero no la mezclo con un estudio como el que se realiza recurriendo al análisis de sistema, como el realizado en "Sistémica de los medios...". Son formas diferentes de entender y acceder al conocimiento. Estudiar la estructura esencial de los medios de comunicación aplicando el análisis sistémico no implica considerar ningún componente del "reino contemplativo", y lo relativo al "reino mental" fue considerado en mi libro anterior "Teoría cognitiva sistémica de la comunicación" (2002), consagrado al sujeto de la comunicación, donde entré en el dominio de la psicología y las operaciones mentales.

Como señalé en dicho libro, "La ciencia tradicional, simplificadora, separa lo físico, lo biológico, lo psicológico, lo sociológico. Pero resulta imposible estudiar el ser humano dividiéndolo tan tajantemente de acuerdo a estas categorías, si bien son útiles para precisar numerosos conceptos y clarificar cómo 'funciona'. No podemos deshacernos de estas distinciones y nos seguirán afectando y conduciendo, como herederos de estas tradiciones disciplinarias. Pero hemos de intentar integrar en un modelo único todo lo que podremos descubrir, para tratar de explicar el fenómeno que nos ocupa: el de la transmisión -y correlativa acumulación- del conocimiento, como elemento central de los procesos de comunicación." (p.77 de la versión impresa, p. 65 de la versión digital)

En consecuencia, debe quedar claro que no renuncio en absoluto a lo que el positivismo absoluto tiende a excluir. Pero el sujeto (y las instituciones o empresas, como "sujetos grupales") no eran objeto de este nuevo libro consagrado a los medios. Y el método sistémico, por definición, se aleja del positivismo, como explicado arriba.

Finalmente, considérese que una teoría (o explicación) científica siempre es una mera propuesta, validada por datos hasta que nuevos datos obliguen a cambiar su formulación. Y toda teoría descansa en algunos supuestos no demostrables, lo cual ha de ser reconocido por el científico si quiere ser honesto. Si quiere conocer mejor mi posición, aconsejo leer mis textos titulados

"¿Ser digital o ser humano?" (n°3 de la

colección de libros de INCOM-Chile) y

"La ciencia y el espíritu: Científicos en busca del alma" (en

ISSUU y

Academia.edu).

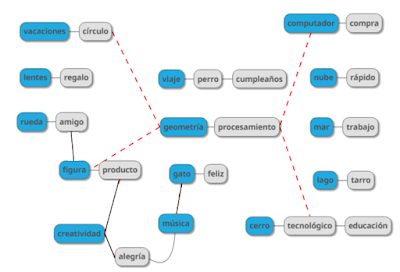

El análisis de macrodatos con el aprendizaje de máquina no utiliza relaciones conceptuales elaboradas. Lo mejor que puede ofrecer es la capacidad de clasificar, sin ninguna capacidad de contextualización, que sería un valor más útil para los negocios. En cambio, las "ontologías" (estructuras de orden semántico) ofrecen la posibilidad de modelar relaciones conceptuales más elaboradas. Este enfoque se conoce como "modelado declarativo" y permiten modelizar problemas del mundo real. Se basa en la sintaxis: sujeto, predicado y objeto son la base de una buena estructura de oración. El desarrollo de ontologías mediante la adopción de este modelo declarativo ha de recorrer aún un largo camino para proporcionar perspectivas contextuales al análisis de datos. Junto con las nuevas arquitecturas de redes neuronales quizás permitan por fin un real avance en una computación dotada de comprensión. (MIT Technology Review, 2/04/2016) .

El análisis de macrodatos con el aprendizaje de máquina no utiliza relaciones conceptuales elaboradas. Lo mejor que puede ofrecer es la capacidad de clasificar, sin ninguna capacidad de contextualización, que sería un valor más útil para los negocios. En cambio, las "ontologías" (estructuras de orden semántico) ofrecen la posibilidad de modelar relaciones conceptuales más elaboradas. Este enfoque se conoce como "modelado declarativo" y permiten modelizar problemas del mundo real. Se basa en la sintaxis: sujeto, predicado y objeto son la base de una buena estructura de oración. El desarrollo de ontologías mediante la adopción de este modelo declarativo ha de recorrer aún un largo camino para proporcionar perspectivas contextuales al análisis de datos. Junto con las nuevas arquitecturas de redes neuronales quizás permitan por fin un real avance en una computación dotada de comprensión. (MIT Technology Review, 2/04/2016) .